Vous connaissez tout sur l’optimisation pour les moteurs de recherche (SEO). L’importance d’un site bien structuré, des mots clés pertinents, des normes techniques et beaucoup de contenu. Mais il y a de fortes chances que vous ne pensiez pas à optimiser Googlebot.

L’optimisation Googlebot n’est pas la même chose que le SEO, car elle va plus loin. Le SEO est davantage axé sur le processus d’optimisation pour les requêtes des utilisateurs. L’optimisation Googlebot est centrée sur la façon dont le crawler de Google accède à votre site.

Il y a beaucoup de points communs, bien sûr. Cependant, faire la distinction est important, parce que l’exploration d’un site est une étape déterminante pour assurer son bon référencement.

Qu’est-ce que Googlebot ?

Googlebot est le robot de recherche de Google qui parcourt le Web et crée un index. On l’appelle aussi « spider ». Le bot parcourt chaque page à laquelle il a accès et l’ajoute à l’index : il pourra ensuite proposer cette page à des utilisateurs utilisant le moteur de recherche de Google.

La façon dont Googlebot explore votre site est cruciale pour comprendre comment optimiser le procédé. Voici les bases :

- Googlebot passe plus de temps à explorer des sites avec un pagerank significatif. Le temps que Googlebot donne à votre site s’appelle « crawl budget ». Plus l’autorité d’une page est grande, plus elle reçoit un budget d’exploration.

- Googlebot parcourt constamment votre site, et plus il y a de contenu récent, de backlinks, de mentions sociales, plus il est probable que votre site apparaisse dans les résultats de recherche. Il est important de noter que Googlebot ne parcourt pas toutes les pages de votre site en permanence. C’est le moment de rappeler l’importance d’un marketing de contenu efficace – un contenu frais attire toujours l’attention du crawler, et améliore la probabilité d’obtenir des pages mieux classées.

- Googlebot accède d’abord au fichier robots.txt d’un site pour connaître les règles d’exploration du site. Toutes les pages qui ne sont pas autorisées ne seront pas indexées.

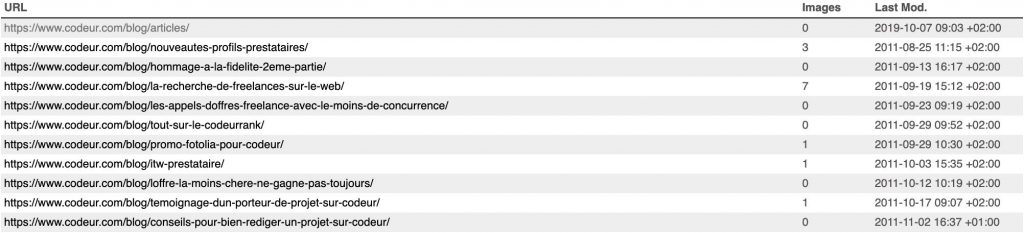

- Googlebot utilise le sitemap.xml pour découvrir toutes les zones du site à explorer et à indexer. En raison des différents façons dont les sites sont construits et organisés, il se peut que le robot ne parcoure pas automatiquement chaque page ou section. Du contenu dynamique, des pages mal classées ou de vastes archives de contenu avec peu de liens internes pourraient bénéficier d’un Sitemap correctement construit.

Optimiser le crawl de ses pages par GoogleBot

Comme l’optimisation Googlebot précède celle pour les moteurs de recherche (SEO), il est important que votre site soit indexé le mieux et le plus précisément possible. Je vais vous expliquer comment faire.

1. Googlebot ne parcourt pas les contenus JavaScript, frames, DHTML, Flash et Ajax. Tout au plus, Google n’a pas été très loquace sur la façon dont son robot analyse JavaScript et Ajax. Comme les opinions sont très variées sur le sujet, vous feriez mieux de ne pas consigner les éléments importants de votre site et/ou de son contenu dans des scripts Ajax/JavaScript. Si vous n’êtes pas capable de voir votre contenu dans un navigateur texte, alors les spiders des moteurs de recherche peuvent avoir le même problème pour parcourir votre site.

2. Améliorez votre fichier robots.txt. Une des raisons pour lesquelles le fichier robots.txt est essentiel est qu’il sert de directive au crawl de Googlebot. Googlebot dispose d’un quota de crawl, et dépensera son budget d’exploration sur n’importe quelles pages de votre site. Vous devez dire au Googlebot où il doit et ne doit pas dépenser ce budget. S’il y a des pages ou des silos de votre site qui ne devraient pas être explorés, modifiez votre fichier robots.txt en conséquence. Moins Googlebot passe de temps sur des sections inutiles de votre site, plus il peut parcourir les sections les plus importantes. Le mode par défaut de Googlebot est de crawler et d’indexer tout. Le but de robots.txt est de dire à Googlebot où il ne doit pas aller. Orientez le crawler uniquement sur le contenu que vous voulez voir ressortir dans Google.

3. Créez du nouveau contenu. Un contenu qui est crawlé fréquemment est plus susceptible de gagner du trafic. Il est crucial d’obtenir que vos pages les moins bien classées soient crawlées aussi souvent que possible. Google aime la nouveauté et son robot rapplique immédiatement après que vous ayez cliqué sur « Publier ».

4. Les liens internes sont une carte que Googlebot peut suivre lorsqu’il parcourt votre site. Plus votre structure de liens interne est solide, plus Googlebot sera en mesure de parcourir votre site. Pour analyser votre structure de liens internes il vous suffit d’aller dans Google Search Console → Liens internes. Si les pages en haut de la liste sont des pages de contenu fort que vous voulez voir dans les SERPs, alors vous faites bien.

5. N’oubliez pas de créer votre fichier Sitemap !

Si vous voulez améliorer les performances et le référencement de votre site, alors vous devriez consacrer du temps et des efforts à l’optimisation Googlebot. Certains webmasters ne réalisent pas la quantité de trafic qu’ils négligent, simplement parce qu’ils n’ont pas accordé l’attention nécessaire à l’optimisation Googlebot. Si vous avez besoin d’un expert pour appliquer ces conseils, déposez gratuitement votre projet sur Codeur.com.