L’indexation et le crawling sont des pratiques centrales de Google qui consistent pour le moteur de recherche à explorer, plus ou moins régulièrement, les pages et contenus d’un site web.

Ces algorithmes, qui déterminent la position des sites, influencent grandement leur trafic.

Nous faisons le point, pour vous, sur l’ensemble des éléments à connaître pour une meilleure maîtrise de votre référencement SEO.

1. L’organisation des recherches sur le web

La structuration et la position d’un site sur les moteurs de recherche représentent un travail colossal d’organisation.

En effet, Internet compte plus de 4,1 milliards d’utilisateurs dans le monde.

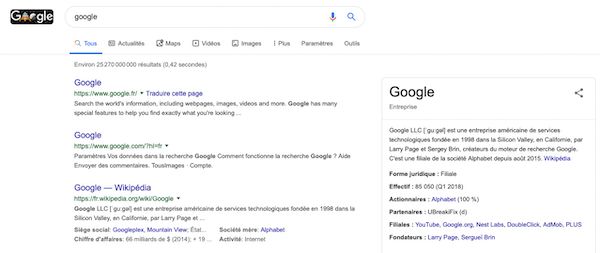

Avec plus de 30 000 milliards de pages indexées par le moteur de recherche Google , une simple recherche peut générer plus de 25 milliards de résultats.

En 2018, pas moins de 1,4 milliard de sites ont vu le jour. La tendance risque donc de s’accentuer dans les années à venir, à plus forte raison que de plus en plus de logiciels permettent aujourd’hui de créer rapidement et simplement un site web.

À lire aussi : Vol de contenu : 7 techniques pour lutter contre le scraping de votre site

2. L’exploration des robots d’indexation Google

Les robots d’indexation Google, appelés Crawlers, ont pour objectif d’analyser les différentes pages web afin d’évaluer leur pertinence et leur autorité.

Cette analyse permet de déterminer un pagerank et une position sur les moteurs de recherche.

On nomme ce concept d’analyse le « budget crawl ». Il occupe une place prépondérante dans l’optimisation du SEO.

Pour améliorer la position des pages, les experts SEO cherchent, entre autres, à :

- augmenter le temps de présence des robots d’indexation sur leur site. Plus il sera conséquent, plus l’analyse sera fine.

- travailler en priorité sur les pages que Google doit indexer. C’est ce que les spécialistes appellent la « réserve de budget crawl ».

En effet, une indexation qui porte sur les pages les moins SEO-friendly va avoir des conséquences négatives sur le positionnement SERP.

Il convient de noter que le crawling Google concerne près de 20 milliards de sites par jour. Ce travail permet ainsi de proposer des résultats qualitatifs en une fraction de seconde.

L’outil Google Search Console permet de réaliser un rapport de couverture d’index. Ce rapport indique le nombre et le détail des pages que Google a indexées.

Il s’agit d’une première étape permettant de comprendre le positionnement d’un site.

À lire aussi : Google Search Console : 5 points à vérifier régulièrement.

3. Le mécanisme des algorithmes Google

Les algorithmes de recherche sur Google fonctionnent en combinant plusieurs informations essentielles. Ainsi, Google prend en compte :

- Les mots-clés indiqués dans la barre de recherche par l’internaute. L’analyse de la requête prend également en compte les fautes d’orthographe ou les erreurs syntaxiques.

- La langue de l’internaute. L’affichage de résultats en langue étrangère pourrait poser de réels problèmes de navigation.

- Les mots-clés présents sur les différents sites internet. La présence et la densité de ces mots-clés doivent être pertinentes et en rapport avec la requête.

- L’ergonomie, la structure et les pratiques des sites web. En effet, certains éléments (voir plus bas) peuvent pénaliser un site et abaisser son positionnement SERP.

Il est important de souligner que le moteur de recherche Google analyse également les informations personnelles de l’internaute.

Ainsi, les résultats obtenus peuvent être individualisés en fonction du lieu de résidence, des paramètres sélectionnés ou des recherches antérieures.

Cette personnalisation explique pourquoi le détenteur d’un site va voir son site apparaître régulièrement en page 1. Cela ne signifie pas que le site en question est bien référencé pour les autres internautes.

Les annonces payantes de Google apparaissent également en fonction de l’analyse des recherches des internautes. Néanmoins, le fait d’opter pour le référencement payant n’améliore pas le référencement naturel.

En d’autres termes, la stratégie SEA ne donne pas de meilleurs résultats SEO.

4. L’importance de la qualité de recherche

Google attache une grande importance à la qualité des recherches des internautes.

Cela suppose de lutter contre l’ensemble des mauvaises pratiques de certains sites internet.

En effet, certaines entreprises ont eu la tentation de manipuler les robots d’indexation pour gagner artificiellement des places dans les résultats.

Avec ses opérations de crawling, Google lutte ainsi contre certaines pratiques précises :

- Les fermes à clics qui visent à insérer de nombreux liens sur ces pages. En théorie, la présence de liens externes peut être une source de bon positionnement.

- Les articles suroptimisés en mots-clés. Les logiciels SEO indiquent, par exemple, qu’un mot-clé doit être présent entre 0,5 et 3 %.

Au-delà, les robots d’indexation considèrent qu’il y a un risque de suroptimisation et que le contenu n’est peut-être pas pertinent. - Les contenus dissimulés (cloaking), les articles dupliqués ou les liens cassés qui gênent la navigation des internautes. En effet, le contenu obtenu ne correspond pas du tout à ce qui était annoncé sur le moteur de recherche. Ces pratiques sont très pénalisantes.

À lire aussi : SEO : 7 types de liens qui vous pénalisent sur Google.

5. L’amélioration du référencement sur le web

Afin d’améliorer votre position sur les moteurs de recherche, comme Google, nous vous conseillons de suivre les étapes suivantes :

- La réalisation d’un audit complet de votre site. Cet audit va travailler sur le temps de chargement du site, les mots-clés principaux et le respect des critères SEO de référencement naturel.

- La création d’un sitemap via Google Search Console. Cet outil permet d’indiquer, à Google, les pages prioritaires pour les opérations de crawling.

Il est important de déterminer le format du sitemap, d’opter pour l’encodage recommandé et de choisir une forme canonique optimale pour les URLs. - La mise en place d’une stratégie d’Inbound Marketing. Cette méthodologie permet de miser sur un flux de visiteurs « qualifiés ».

Il s’agit d’un excellent moyen de développer son activité sans rechercher un trafic maximal. - La veille sur les évolutions des algorithmes de Google. En effet, le moteur de recherche met régulièrement à jour son fonctionnement pour renforcer la pertinence des résultats.

La compréhension des algorithmes de Google et du crawling nécessite expérience et expertise.

N’hésitez pas à demander les services d’un prestataire qualifié pour augmenter votre référencement sur le web sur Codeur.com.

Article rédigé par Amaury.